Новые правила в Robots.txt для Яндекса

Обновления правил Robots.txt в Яндекс

Буквально минут 30 назад в Яндекс.Вебмастере получил сообщение «Новые правила обработки директив Allow и Disallow в файлах robots.txt».

На самом деле, никаких резких изменений не произошло.

Вот это сообщение:

Добрый день!

Уведомляем вас об изменениях в

обработке директивы ‘Allow’ файла robots.txt, с помощью которого вы можете разрешить или запретить индексирование сайта поисковым роботом Яндекса.По новым правилам, если страница сайта попадает под действие нескольких директив ‘Allow’ и/или ‘Disallow’, то будет применяться директива с наибольшей длиной префикса URL. При определении длины префикса спецсимвол ‘*’ не учитывается.

Если на вашем сайте в robots.txt совместно используются директивы ‘Allow’ и ‘Disallow’, пожалуйста, проверьте их на соответствие новым стандартам. В этом вам поможет наша форма проверки robots.txt.

Подробнее об использовании директив вы можете прочитать в Помощи.

—

С уважением,

Яндекс.Вебмастер

http://webmaster.yandex.ru

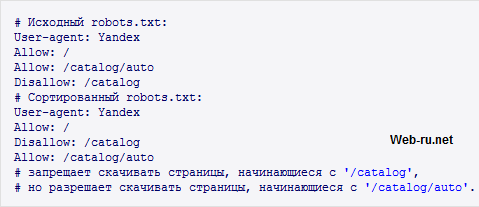

Очевидно, что теперь в Robots.txt для Яндекса директивы Allow и Disallow будут упорядочены по длине URL в правиле, и исходный порядок их в данном файле перестал иметь значение:

Robots.txt для Яндекс

Ранее, например, такая запись

Allow: */page/

Disallow: /

говорила роботу о том, что можно индексировать страницы лишь с адресами вида http://…/page/…

А такая запись

Disallow: /

Allow: */page/

запрещала индексирование всего сайта. Теперь 2-я запись будет преобразована к 1-й (путём сортировки) и в обоих случаях произойдёт индексация страниц http://…/page/…

Едва ли это повлияло на большинство сайтов (хотя, на всякий случай проверьте свои robots’ы в этой форме — http://webmaster.yandex.ru/robots.xml).

Вообще, не очень ясно, для чего Яндекс ввёл новые правила в файле robots.txt. Ведь по сути ничего не изменилось..

Проверка бэклинков сайта сервисами MajesticSEO.com и Ahrefs.com...в сайта опишу весьма популярные на Западе сервисы для анализа SEO-показателей

Проверка бэклинков сайта сервисами MajesticSEO.com и Ahrefs.com...в сайта опишу весьма популярные на Западе сервисы для анализа SEO-показателей  Что такое партнерская программа. Примеры партнерских программ....в – тысячи. Некоторые из них, ну так себе (мягко говоря), другие

Что такое партнерская программа. Примеры партнерских программ....в – тысячи. Некоторые из них, ну так себе (мягко говоря), другие  Что такое файл Robots.txt? Настройка, спецсимволы и директивы Allow/Disallow, Sitemap, Host, User-agent... # повторяем всё для Яндекса...

Disallow:

Что такое файл Robots.txt? Настройка, спецсимволы и директивы Allow/Disallow, Sitemap, Host, User-agent... # повторяем всё для Яндекса...

Disallow:  Как купить уникальные статьи бесплатно. Применим Profit-partner.ru...но сразу сделать заказ, расплатившись с копирайтерами бонусами, а можно сначала перевести

Как купить уникальные статьи бесплатно. Применим Profit-partner.ru...но сразу сделать заказ, расплатившись с копирайтерами бонусами, а можно сначала перевести  Что такое веб-сервер, Denwer (Денвер), локальный сервер localhost и phpMyAdmin...редназначенная для администрирования БД (создание/удалений таблиц,

Что такое веб-сервер, Denwer (Денвер), локальный сервер localhost и phpMyAdmin...редназначенная для администрирования БД (создание/удалений таблиц,

Здравствуйте Пётр! Помогите пожалуйста разобраться с файлом robots.txt

Чего надо убрать, а чего добавить. Заранее спасибо!!!

User-agent: Googlebot-Image

Disallow: /

User-agent: YandexImages

Disallow: /

User-agent: msnbot-MM

Disallow: /

User-agent: Googlebot-Mobile

Allow: /*wap

Disallow: /

User-agent: YandexImageResizer

Allow: /*wap

Disallow: /

User-agent: MediaPartners-Google

Allow: /

User-agent: Baiduspider

Disallow: /

User-agent: *

Allow: /$

Allow: /*action=.xml

Disallow: /*action

Disallow: /*wap

Disallow: /*board=*wap

Disallow: /*topic=*wap

Disallow: /*topic=*.msg

Disallow: /*topic=*.new

Disallow: /*;

Disallow: /*PHPSESSID

Allow: /*board

Allow: /*topic

Disallow: /

Crawl-delay: 5

Clean-param: PHPSESSID /index.php

Host: inforiches-forum.ru

Здравствуйте!

Ну и Robots у вас…

Например, знаете, что это такое: User-agent: Baiduspider? — это вы «приглашаете» китайский поисковик Baidu, он вам нужен?

Удалите всё, что до User-agent: *

В остальном тоже, всё, скорей всего, неправильно (надо разбираться со структурой вашего сайта).

Здравствуйте Пётр! Я и попал к Вам на этот блог после просмотра этого курса в надежде на помощь.

Всё по удалял и оставил так:

User-agent: *

Allow: /$

Disallow: /*action

Disallow: /*topic=*.msg

Disallow: /*topic=*.new

Disallow: /*;

Disallow: /*ID

Allow: /*board

Allow: /*topic

Disallow: /

Host: inforiches-forum.ru

Георгий, Disallow: / — вот это означает запретить к индексации весь сайт. Так не надо делать.

Посмотрите справку Яндекса: http://help.yandex.ru/webmaster/?id=996567#996571

В общем, сделайте так для начала:

User-agent: *Disallow:

User-agent: Yandex

Disallow:

Host: inforiches-forum.ru

В остальном — надо изучать структуру сайта.

Добрый лень Пётр! Здесь вы прописали для яндекса

User-agent: Yandex

Disallow:

а как прописать для других поисковиков?

Спасибо, Пётр! Мне кажется вам действительно надо создать обучающий курс по SEO оптимизации. Я думаю желающих купить его будет масса. Ваш бесплатный курс даёт много понятий о этом. =)

Не за что

Благодарю, Георгий, за добрые слова

Здравствуйте, Георгий!

Вот так: User-agent: *

Звёздочка буквально и переводится как «все поисковики».

Здравстуйте Пётр! пожалуйста помоги чайнику я добавил файл Sitemap в Яндекс а мне показывает 15 ошибок «Некорректный URL» (не соответствует местоположению файла Sitemap) я туту в нете нашел вот тот форум forum.searchengines.ru/archive/index.php/t-241621.html что нужно в файле robots.txt после «User-agent: Yandex» прописать строчку Allow: / и тогда все заработает. правда google приняло, все замечательно работает, а вот Яндексюра показывает 15 ошибок.

Рlease проверьте правильно ли составлен robots.txt

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag/

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag/

Host: goldlineextra.com

Sitemap: goldlineextra.com/sitemap.xml.gz

Sitemap: goldlineextra.com/sitemap.xml

Здравствуйте, Василий,

читайте это:

http://web-ru.net/prodvizhenie-sajta/seo/chto-takoe-fajl-robots-txt-nastrojka-specsimvoly-i-direktivy-allow-disallow-sitemap-host-user-agent.html

и

http://web-ru.net/prodvizhenie-sajta/seo/sozdanie-robots-txt-dlya-raznyh-robotov-google-i-yandex.html